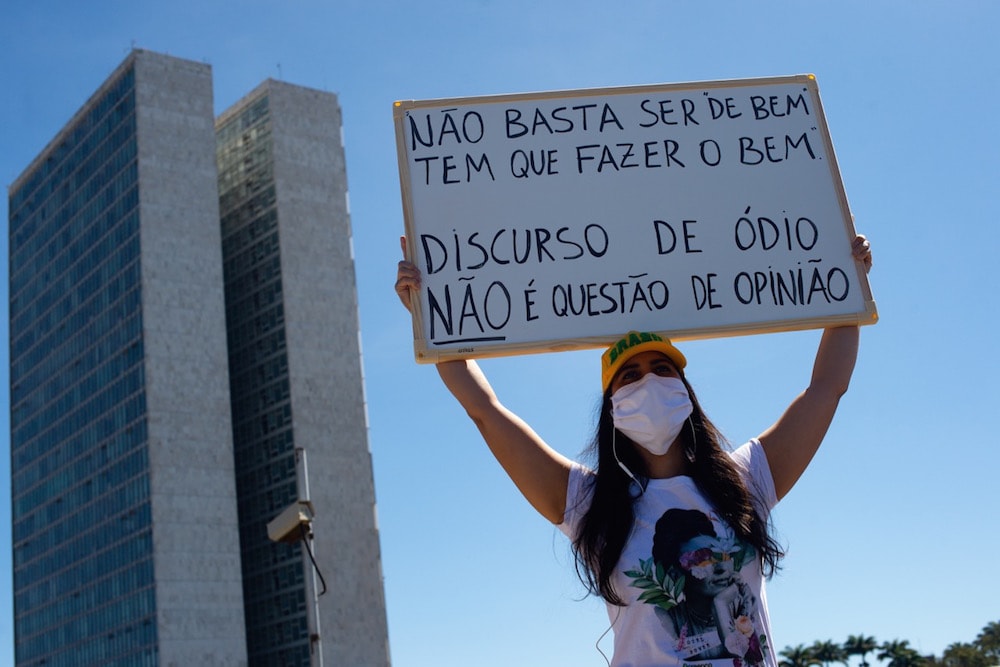

Los límites entre el discurso de odio -no amparado por la libertad de expresión- y los contenidos que pudieran resultar chocantes o perturbadores, que sí lo están, se vuelven difusos y subjetivos.

Este artículo fue publicado originalmente en adc.org.ar el 1 de octubre de 2020.

En la actualidad, el discurso de odio es uno de los temas más controversiales cuando de regulación de internet se trata. Las dificultades para arribar a consensos jurídicos y sociales acerca de su definición nos impulsaron a indagar sobre su caracterización en América Latina. El resultado fue publicado en abril de este año bajo el título Más que palabras.

Como parte de su elaboración, se realizaron catorce entrevistas a activistas e integrantes de la comunidad lésbica de Argentina, Brasil, Costa Rica y Panamá. El valioso contenido de los encuentros nos dejó interrogantes que excedían al objeto de análisis inicial, pero que estamos compartiendo a través de cuatro artículos. El primero de ellos se refirió a la relación de haters, bots y trolls con el uso del anonimato y puede leerse aquí.

Las experiencias compartidas por Michele Seixas y Camila Marins -de Brasil- fueron el punto de partida de esta segunda entrega. En las siguientes líneas, describiremos brevemente la labor de moderación de contenidos llevada a cabo por las plataformas.

«… en mis redes he padecido numerosos ataques. Recientemente, en Facebook sufrí varios bloqueos en las fotos de mi boda. […] Los bloqueos también provienen de prejuicios sociales.»

Camila Martins

La moderación de contenidos puede definirse como el proceso de revisión, edición y verificación de los contenidos creados y compartidos por los y las usuarias con el fin de detectar posibles transgresiones a las normas internas de las plataformas.

Las plataformas operadas por intermediarios del sector privado establecen, con frecuencia, normas comunitarias que -entre otras cuestiones – determinan qué tipo de contenidos están prohibidos, cuáles serán las sanciones y qué mecanismos existen para apelar una decisión tomada si el o la usuaria cree que es incorrecta.

Generalmente, normas comunitarias y políticas de moderación se presentan asociadas a los términos de uso, que los y las usuarias deben aceptar para utilizar las redes sociales. No obstante, estos son cada vez más extensos y complejos, dificultando su atenta lectura y, más aún, el mantenerse actualizado de las modificaciones que van registrando.

Los contenidos prohibidos o merecedores de sanción suelen estar asociados a la comisión de delitos como, entre otros, la pornografía y el acoso o la vulneración de los derechos de autor. Sin embargo, los límites entre el discurso de odio -no amparado por la libertad de expresión- y los contenidos que pudieran resultar chocantes o perturbadores, que sí lo están, se vuelven difusos y subjetivos. La diferenciación entre estos tipos de discursos es decisión exclusiva de cada intermediario y, por ello, su caracterización -e incluso el término con que se los define- puede variar en las distintas plataformas.

Otra diferencia en la moderación de contenidos de las plataformas es su modelo de aplicación. Existen diferentes combinaciones de mecanismos de revisión manual y automáticos, de cuyo funcionamiento se encuentra información incompleta. Si bien algunas plataformas han avanzado bastante en términos de transparencia, aún estamos lejos de una situación ideal.

Estos mecanismos pueden aplicarse antes o después de que los contenidos estén en línea. La primera opción puede traer aparejada la pérdida de inmediatez en la publicación, mientras que la segunda puede suponer un periodo de exposición en línea más prolongado de los contenidos inapropiados, hasta ser revisados y sancionados por el moderador.

Optimizar los tiempos de revisión y reducir los costos de la moderación efectuada por seres humanos, ha llevado a las plataformas a apoyarse cada vez más en soluciones automáticas basadas en el uso de algoritmos. Las medidas de aislamiento y distanciamiento social provocadas por el Covid-19 han intensificado esta situación, ya que ha disminuido el nivel de revisión humana. (1)

Cada modelo de moderación tiene sus pros y contras para las empresas, pero también para quienes utilizan las plataformas. La efectividad de los mecanismos que implementen dependerá de sus alcances y las posibles afectaciones a los derechos fundamentales de sus usuarios y usuarias, pero también de los instrumentos que se le ofrezcan para denunciar contenidos y cuentas, que contribuyan a identificar las transgresiones a las normas comunitarias.

Eventuales errores en el diseño de la revisión manual y automática, como resultado de diferencias idiomáticas, e interpretativas de los contextos socio – culturales que dotan de sentido a los contenidos en línea, pueden producir remociones y sanciones infundadas.

(1) Observatorio Latinoamericano de Regulación, Medios y Convergencia (Observacom). (2020, 2 abril). OBSERVACOM alerta sobre el impacto para la libertad de expresión de la censura algorítmica de plataformas en tiempos de COVID-19. Recuperado de https://www.observacom.org/observacom-alerta-sobre-el-impacto-para-la-libertad-de-expresion-de-la-censura-algoritmica-de-plataformas-en-tiempos-de-covid-19/